爬虫python入门教程:Python爬虫入门教程,从零开始掌握网络数据抓取

在当今数据驱动的时代,网络爬虫成为了获取数据的重要工具,Python凭借其简洁的语法和丰富的库,成为了编写爬虫程序的首选语言,本文将带你从零开始,逐步掌握Python爬虫的基础知识和实战技巧。

什么是网络爬虫?

网络爬虫(Web Crawler)是一种按照一定的规则自动抓取互联网信息的程序,它通过模拟浏览器行为,访问网页、解析内容、提取数据,并将数据存储起来,供后续分析使用。

为什么选择Python?

- 简单易学:Python语法简洁,学习曲线平缓。

- 丰富的库:如

requests、BeautifulSoup、Scrapy等,极大简化了爬虫开发。 - 强大的社区支持:遇到问题时,可以轻松找到解决方案。

- 跨平台性:Python可以在Windows、Mac、Linux等多种系统上运行。

爬虫开发基础

HTTP请求

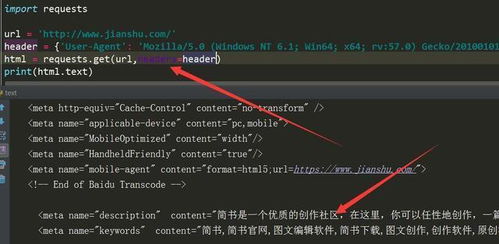

爬虫的核心是发送HTTP请求并获取响应,Python中常用的库是requests。

import requests url = 'https://example.com' response = requests.get(url) print(response.text)

解析HTML

获取到的网页内容是HTML格式,需要解析提取所需数据。BeautifulSoup是一个常用的HTML解析库。

from bs4 import BeautifulSoup html_content = '<html><body><h1>Hello World</h1></body></html>' soup = BeautifulSoup(html_content, 'html.parser') print(soup.h1.text) # 输出:Hello World

数据存储

爬取的数据可以保存为JSON、CSV或数据库文件,使用json库保存数据:

import json

data = {'name': 'Alice', 'age': 25}

with open('data.json', 'w') as f:

json.dump(data, f) 实战:爬取一个简单网页

下面是一个完整的例子,爬取一个网页的标题:

import requests

from bs4 import BeautifulSoup

# 发送HTTP请求

url = 'https://example.com'

response = requests.get(url)

# 检查请求是否成功

if response.status_code == 200:

# 解析HTML

soup = BeautifulSoup(response.text, 'html.parser')

# 提取标题= soup.title.text

print(f'网页标题:{title}')

else:

print(f'请求失败,状态码:{response.status_code}') 反爬虫策略与应对

随着爬虫技术的发展,网站也采取了多种反爬措施:

- User-Agent检测:模拟浏览器访问,设置合理的User-Agent。

- IP限制:频繁请求会被封IP,建议使用代理或延时。

- 验证码:遇到验证码时,可以尝试使用验证码识别服务。

进阶:使用Scrapy框架

对于复杂的爬虫项目,Scrapy是一个强大的框架,提供了完整的爬虫生命周期管理。

# Scrapy项目中的一个简单爬虫示例

import scrapy

class ExampleSpider(scrapy.Spider):

name = 'example'

start_urls = ['https://example.com']

def parse(self, response):

self.logger.info('Visited %s', response.url)

# 提取数据

title = response.css('title::text').get()

yield {'title': title} Python爬虫入门并不难,通过掌握基础的HTTP请求、HTML解析和数据存储,你已经可以开始编写简单的爬虫程序了,随着学习的深入,你可以尝试使用Scrapy等高级框架,处理更复杂的爬虫任务。

希望这篇入门教程能帮助你开启爬虫之旅!如果你对爬虫感兴趣,不妨从一个简单的项目开始,逐步积累经验。

相关文章:

文章已关闭评论!