爬取一个网站的多个页面数据:目标网站的起始URL

实战指南

在当今数据驱动的时代,网络爬虫成为获取网站数据的重要工具,无论是进行市场分析、学术研究,还是构建数据驱动的应用,爬取多个页面的数据都是常见的需求,本文将详细介绍如何通过编程手段爬取一个网站的多个页面数据,并提供实用的代码示例和注意事项。

什么是网页爬取?

网页爬取(Web Scraping)是指通过自动化程序从网页中提取结构化数据的过程,与手动复制粘贴相比,爬取工具可以高效、快速地获取大量数据,尤其适用于需要定期更新数据的场景。

爬取多个页面的步骤

爬取一个网站的多个页面数据通常包括以下几个步骤:

确定目标网站和爬取范围 明确你要爬取的网站URL以及需要爬取的页面范围,你可以选择爬取某个新闻网站的所有文章页面,或者某个电商网站的所有产品页面。

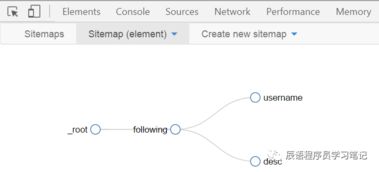

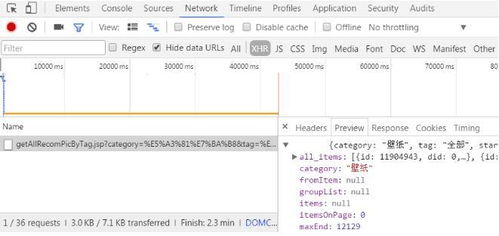

分析网页结构 在编写爬虫代码之前,需要分析目标网页的HTML结构,确定数据所在的标签和属性,可以使用浏览器的开发者工具(如Chrome的Inspect功能)来查看网页的HTML结构。

发送HTTP请求 使用编程语言(如Python)发送HTTP请求到目标URL,获取网页的HTML内容,常用的库包括Python的

requests库。

解析HTML内容 从获取的HTML内容中提取所需的数据,可以使用HTML解析库(如

BeautifulSoup)或解析器(如lxml)来完成这一任务。处理多个页面 通过循环或递归的方式,遍历目标网站的多个页面,重复发送请求和解析HTML的过程,从而获取所有页面的数据。

存储数据 将爬取的数据存储到文件(如CSV、JSON)或数据库中,以便后续分析和使用。

代码示例:使用Python爬取多个页面

以下是一个使用Python爬取多个页面的简单示例,我们将使用requests库发送HTTP请求,使用BeautifulSoup解析HTML,并提取每个页面的标题。

import requests

from bs4 import BeautifulSoup

base_url = "https://example.com/page-"

# 定义要爬取的页面数量

num_pages = 5

# 存储所有页面标题的列表s = []

# 循环遍历每个页面

for page in range(1, num_pages + 1):

# 构建当前页面的URL

url = base_url + str(page)

# 发送HTTP请求

response = requests.get(url)

# 检查请求是否成功

if response.status_code == 200:

# 解析HTML内容

soup = BeautifulSoup(response.text, 'html.parser')

# 提取标题(假设标题在<h1>标签中)

title = soup.find('h1').get_text()

titles.append(title)

print(f"Page {page}: {title}")

else:

print(f"Failed to retrieve page {page}. Status code: {response.status_code}")

保存到CSV文件

import csv

with open('titles.csv', 'w', newline='') as file:

writer = csv.writer(file)

writer.writerow(['Page', 'Title'])

for i, title in enumerate(titles, 1):

writer.writerow([i, title]) 注意事项

遵守网站的

robots.txt大多数网站都有robots.txt文件,规定了爬虫可以访问的页面范围,爬虫应遵守这些规定,避免对网站造成不必要的负担。处理反爬措施 一些网站会采取反爬措施,如IP封禁、验证码等,在这种情况下,可能需要使用代理IP、模拟用户代理(User-Agent)或使用更高级的爬虫框架(如Scrapy)。

法律和道德问题 在爬取数据时,务必确保遵守相关法律法规和网站的使用条款,未经允许爬取数据可能构成侵权或违反法律。

处理动态内容 对于使用JavaScript动态加载内容的网站,简单的HTTP请求可能无法获取完整数据,可以使用无头浏览器(如Selenium)或爬虫框架(如Scrapy)来处理。

爬取一个网站的多个页面数据是一个强大且实用的技能,通过本文的介绍和示例,你应该对如何实现这一过程有了基本的了解,在爬取数据时,始终要遵守道德和法律规范,确保你的爬虫行为不会对目标网站造成负面影响。

如果你需要更复杂的爬取任务,可以考虑使用专业的爬虫框架(如Scrapy)或服务(如八爪鱼),这些工具提供了更高级的功能,如分布式爬取、反爬处理等,能够更高效地完成爬取任务。

相关文章:

文章已关闭评论!