网站源码爬取:网站源码爬取,原理、方法与注意事项

在当今互联网时代,网站源码爬取(Web Scraping)已成为数据采集、信息分析的重要手段,无论是企业运营、学术研究,还是个人兴趣,掌握网站源码爬取的基本原理和方法都具有重要意义,本文将从基础概念、常用工具、法律风险及实践技巧等方面,全面解析网站源码爬取的相关知识。

什么是网站源码爬取?

网站源码爬取是指通过程序自动从网页中提取所需数据的过程,网页本质上是由HTML、CSS、JavaScript等构成的源代码,爬取工具通过解析这些代码,提取出结构化或半结构化的数据,如文本、图片链接、表格内容等。

电商网站的商品信息、新闻网站的标题列表、社交媒体的用户评论等,都可以通过爬取技术获取。

网站源码爬取的常用方法

手动爬取

适用于数据量较小或结构简单的场景,通过浏览器开发者工具查看网页源码,手动复制或编写简单的正则表达式提取数据,但效率低,不适合大规模数据采集。

自动化工具

借助第三方工具或编写脚本实现自动化爬取,常见的有:

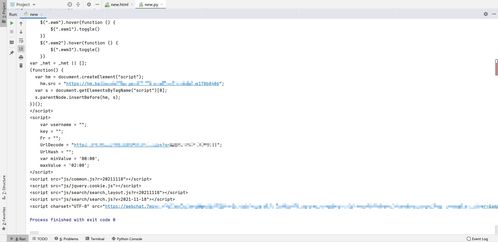

- Beautiful Soup + Requests(Python):适合初学者,Beautiful Soup用于解析HTML,Requests用于发送HTTP请求。

- Scrapy(Python框架):功能强大,适合构建大规模爬虫项目。

- Selenium:用于处理动态网页,模拟浏览器行为,适合爬取需要JavaScript渲染的页面。

- 八爪鱼、爬虫宝等可视化工具:无需编程,适合非技术用户快速上手。

API接口

部分网站提供官方API接口,开发者可以通过API获取数据,这种方式效率高且合法,但并非所有网站都开放API。

网站源码爬取的法律与道德问题

合法性

爬取行为需遵守目标网站的《服务条款》和《robots.txt》协议,未经授权爬取受版权保护的网站内容可能构成侵权。

道德规范

尊重网站的爬取频率限制,避免对服务器造成过大压力,合理使用缓存机制,减少重复请求。

反爬措施

许多网站会设置反爬机制,如IP封禁、验证码、动态加载等,爬虫开发者需合理应对,如使用代理IP、模拟用户行为、绕过验证码等。

网站源码爬取的实践技巧

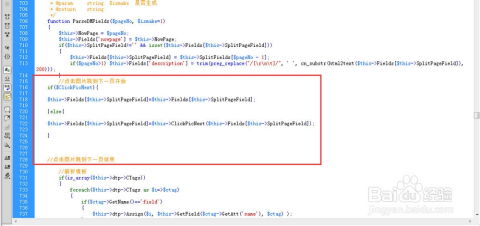

分析网页结构

在爬取前,需通过浏览器开发者工具(F12)查看网页的HTML结构,确定目标数据的标签和属性。

处理动态内容

对于动态加载的网页(如使用Ajax技术),需使用Selenium或Puppeteer等工具模拟浏览器行为,获取完整页面内容。

数据清洗

爬取的数据往往包含无用信息(如广告、空格、乱码等),需通过正则表达式、字符串处理或数据校验进行清洗。

分布式爬取

对于大型网站,可采用分布式爬虫架构,利用多台机器并行爬取,提高效率。

常见爬取工具推荐

| 工具名称 | 适用场景 | 是否需要编程 |

|---|---|---|

| Beautiful Soup | 简单爬取、教育学习 | 需要 |

| Scrapy | 大型爬虫项目 | 需要 |

| Selenium | 动态网页爬取 | 需要 |

| 八爪鱼 | 非技术用户、简单任务 | 不需要 |

| Octoparse | 图形化爬虫工具 | 不需要 |

网站源码爬取是一项实用的技术,能够帮助我们高效地获取网络信息,无论是初学者还是专业开发者,掌握爬取的基本原理和工具都能为数据挖掘、自动化办公提供极大便利,但同时,我们也要时刻注意法律和道德边界,合理合法地使用爬虫技术。

如果你对爬虫感兴趣,可以从简单的Python脚本开始,逐步学习高级爬虫框架和反爬策略,逐步提升技能水平。

参考资源:

相关文章:

文章已关闭评论!