网页源代码提取文字:网页源代码提取文字,从基础到进阶指南

在互联网时代,网页是我们获取信息、进行交流和完成各种任务的主要平台,了解如何从网页源代码中提取文字信息,不仅对于网页开发者和程序员至关重要,对于进行网络研究、信息收集、内容分析甚至解决某些技术问题的用户来说,也是一项非常实用的技能,本文将介绍如何查看和提取网页源代码中的文字内容。

为什么需要从网页源代码提取文字?

- 网页开发与调试: 开发者需要查看源代码来理解网页结构、样式和功能的实现方式,进行调试或学习。

- 内容备份与存档: 有时网页内容可能不稳定或即将消失,提取文字可以进行备份。

- 信息检索与分析: 研究人员或分析师可能需要从大量网页中提取特定文字信息进行统计或分析。

- 文本处理与转换: 将网页内容转换为纯文本文件,用于阅读、打印或导入其他软件处理。

- 反向工程与学习: 通过查看他人网页的源代码,学习优秀的网页设计和编程技巧。

- 解决版权或引用问题: 确认网页上文字内容的原始来源或进行合法引用。

如何查看网页源代码?

查看网页源代码是提取文字的第一步,以下是几种常用方法:

-

右键菜单 -> 查看页面源代码:

- 这是最简单直接的方法,在任何网页上,单击鼠标右键,选择“查看页面源代码”(或类似名称,如“View Page Source”)。

- 这会打开一个新标签页,显示该网页的原始HTML源代码,注意,这显示的是服务器最初发送给浏览器的代码,不包含浏览器渲染后动态添加或修改的内容(JavaScript生成的内容)。

- 在这个源代码页面里,你可以直接选中文本进行复制。

-

开发者工具:

- 现代浏览器(如 Chrome, Firefox, Edge)都内置了强大的开发者工具。

- 通常可以通过右键点击页面任意位置,选择“检查”或“Inspect Element”来快速打开开发者工具。

- 在开发者工具中,切换到“Elements”(元素)标签页,可以看到当前页面DOM树的实时渲染状态,这比纯HTML源代码更直观,但本质上也是基于HTML。

- 也可以在开发者工具的“Sources”(源代码)标签页中查看网络请求返回的原始HTML文件。

-

浏览器内置功能:

- Chrome/Safari: 按

Command + Option + P(Mac) 或Ctrl + Shift + I(Windows/Linux) 可能会打开开发者工具,或者在某些版本中,Ctrl + U(Windows/Linux) 或Command + U(Mac) 可以直接查看源代码。 - Firefox: 按

Ctrl + Shift + C(Windows/Linux) 或Command + Shift + C(Mac) 可能会打开检查工具,或者使用View -> Page Source。 - Edge: 与Chrome类似,使用快捷键或右键菜单。

- Chrome/Safari: 按

如何从网页源代码中提取文字?

一旦你获得了网页的源代码,就可以从中提取文字了,以下是几种方法:

-

手动查找与复制:

- 在源代码编辑器(如浏览器的源代码标签页或记事本)中,查找

<body>标签开始,然后寻找所有包含文本的 HTML 标签,如<p>、<h1>到<h6>、<div>、<span>等。 - 直接在源代码中选中文本并复制,缺点是效率低下,且需要对 HTML 标签有一定了解才能跳过无关的代码(如

<script>、<style>标签)。

- 在源代码编辑器(如浏览器的源代码标签页或记事本)中,查找

-

使用正则表达式(Regex):

- 对于熟悉编程或文本处理的用户,可以使用正则表达式来匹配和提取文本内容。

- 一个非常基础的正则表达式可以匹配大部分文本内容,

/<[^>]*>/g用于移除所有 HTML 标签,留下纯文本,但请注意,正则表达式处理 HTML 可能会遇到复杂情况(如嵌套标签、属性等)而变得复杂,且不是万无一失的。

-

编程语言实现:

-

对于批量处理或自动化任务,可以使用编程语言来实现网页源代码的获取和文字提取。

-

步骤:

- 获取源代码: 使用语言提供的网络请求库(如 Python 的

requests, JavaScript 的fetch/XMLHttpRequest, Java 的HttpURLConnection等)向目标网页发送请求,获取返回的 HTML 文本。 - 解析与提取: 使用专门的 HTML 解析器库(如 Python 的

BeautifulSoup或lxml, JavaScript 的DOMParser等)来解析 HTML 文本,这些库可以智能地处理 HTML 结构,让你能够根据标签名、属性、类名、ID 等选择器来定位和提取特定的文本内容。

- 获取源代码: 使用语言提供的网络请求库(如 Python 的

-

示例(Python 使用 BeautifulSoup):

import requests from bs4 import BeautifulSoup # 发送请求获取网页内容 url = 'https://example.com' response = requests.get(url) html_content = response.text # 解析 HTML soup = BeautifulSoup(html_content, 'html.parser') # 提取整个页面的文本(去除HTML标签) page_text = soup.get_text() # 或者提取特定标签的文本,例如所有的段落 paragraphs = soup.find_all('p') for p in paragraphs: print(p.get_text()) # 或者进行其他操作 -

这种方法是最强大和灵活的,但也需要一定的编程知识。

-

注意事项

- 合法性与道德: 在提取网页文字时,请务必遵守相关网站的

robots.txt文件规定(如果存在),尊重网站的版权和使用条款,不要用于非法目的或大规模、自动化地抓取受保护的内容,以免构成网络爬虫攻击或侵犯版权。 - 对于由 JavaScript 动态生成的网页内容(如社交媒体帖子、新闻评论等),简单的 HTML 请求可能无法获取到源代码中的内容,因为这些内容是在浏览器端执行 JS 后才生成的,这时需要使用浏览器自动化工具(如 Selenium, Puppeteer)来模拟浏览器行为,获取最终渲染后的页面内容。

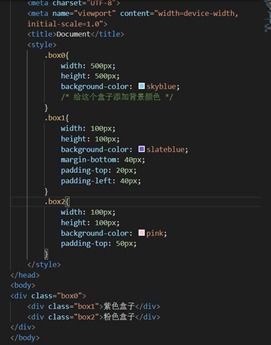

- 编码问题: 确保处理文本时考虑网页的字符编码(通常在 HTML 的

<head>部分有声明,如<meta charset="UTF-8">),以避免乱码。

从网页源代码中提取文字是一个结合了基础操作和高级技术的过程,对于简单的任务,手动查看或使用基础工具即可;对于复杂或批量的任务,则需要借助编程和专业的 HTML 解析库,无论采用哪种方法,都应牢记合法合规、尊重版权的原则,掌握这项技能,能让你更深入地理解和利用网络信息资源。

相关文章:

文章已关闭评论!